(source : GCP qiwklabs)

AI Platform Notebooks 생성

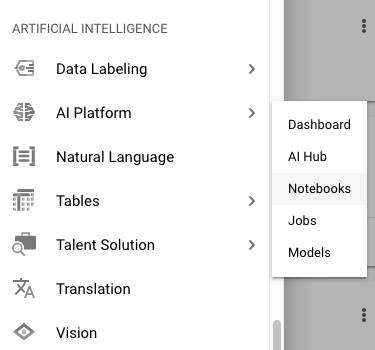

1. Navigation Menu > AI Platform > Notebooks 클릭

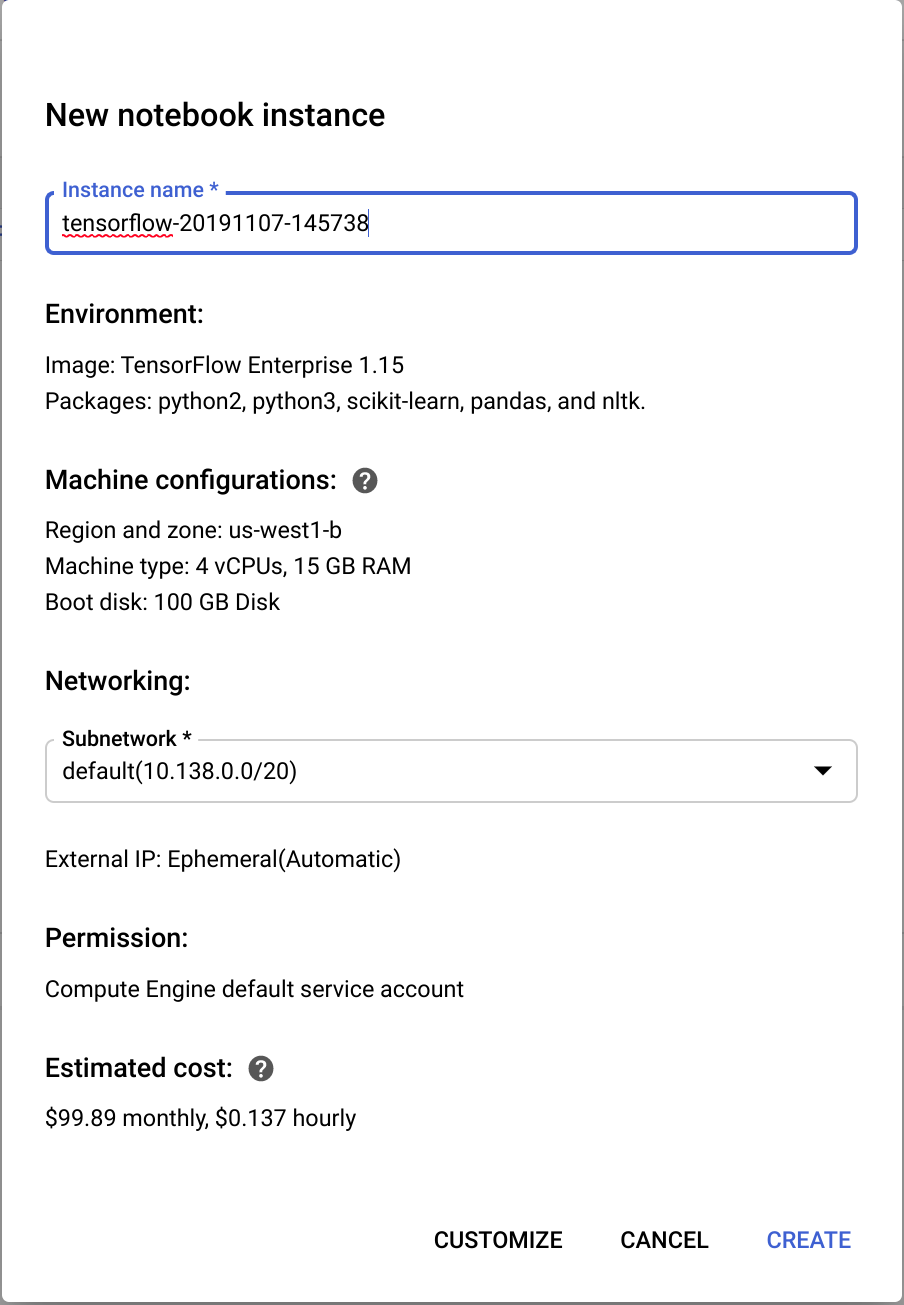

2. 인스턴스 생성 : NEW INSTANCE 클릭

- Tensorflow Enterprise 1.15 > Without GPUs 선택

3. 팝업창이 뜨면 딥러닝 VM 이름을 입력/확인 하고 Create 클릭

(VM 생성까지 2~3분 정도 소요될 수 있음)

4. Open JupyterLab 클릭 > JupyterLab Window가 새창으로 열림

Datalab instance에 학습용 repo 복제

- training-data-analyst 를 내 JupyterLab 인스턴스에 복제

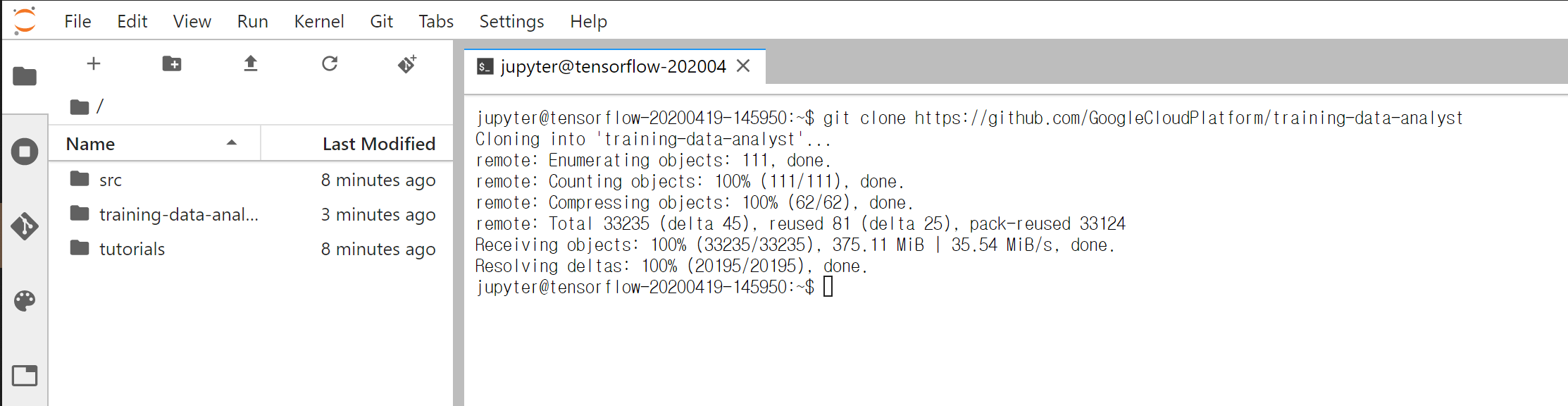

1. JupyterLab 에서 터미널 아이콘(Terminal icon) 클릭하여 새 터미널 창을 오픈

2. 커맨드라인에서 아래 명령어를 입력하고 Enter

git clone https://github.com/GoogleCloudPlatform/training-data-analyst

실행 결과 :

3. training-data-anlyst 디렉토리를 더블 클릭하여 컨텐츠가 제대로 복제되었는지 확인

API key 받기

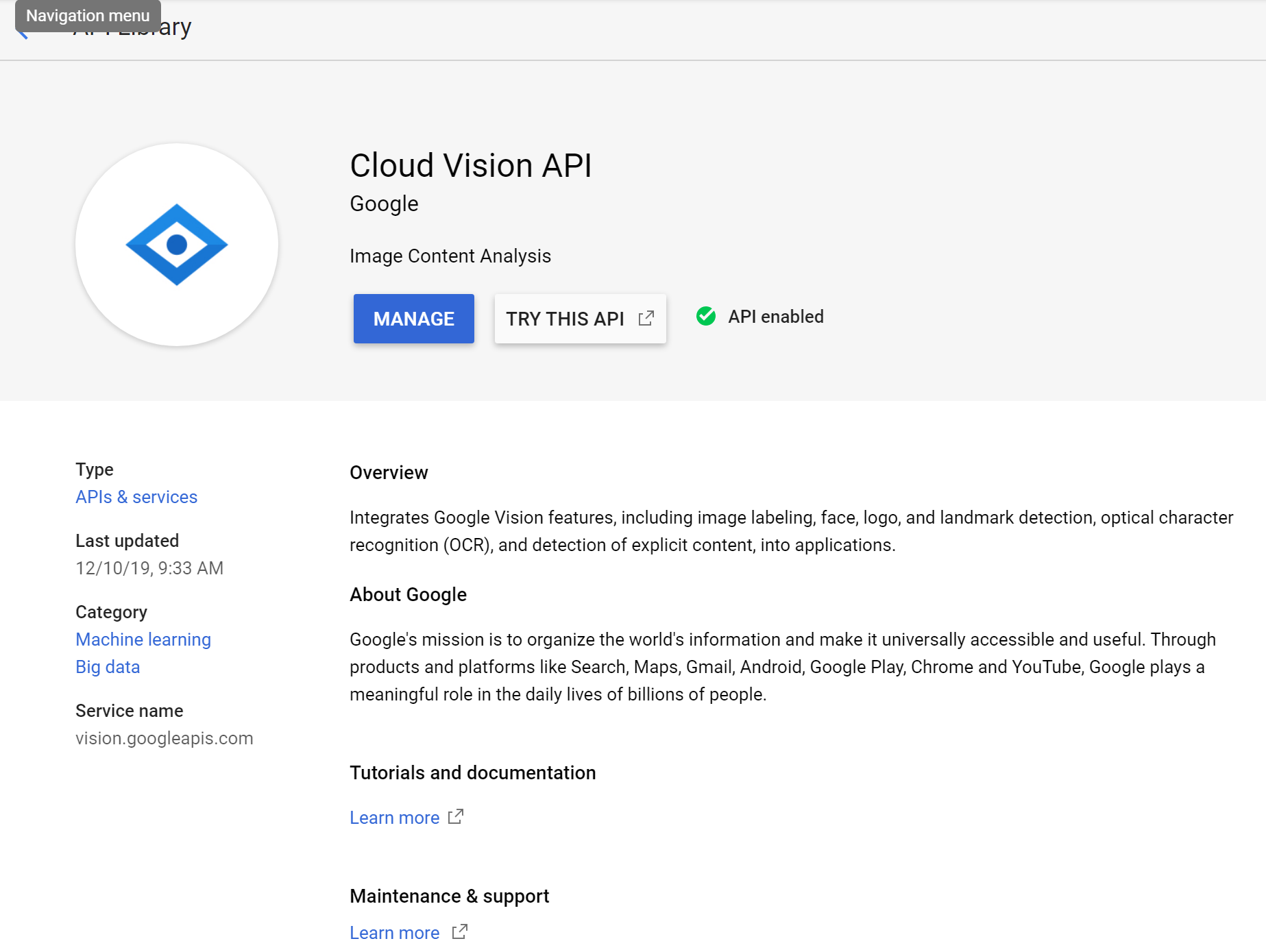

1. GCP console > APIs and services > Library 클릭

2. 검색창(search box)에서 > "vision" 을 타이핑 > Google Cloud Vision API 클릭

- 활성화 되어 있지 않다면 Enable 클릭

3. 같은 방법으로 Translate API, Speech API, and Natural Language APIs 를 활성화

4. GCP console menu > APIs and services > Credentials 선택

5. Create credentials > API key 클릭 (API Key 사용을 위해 생성된 키 값을 복사해 둠)

AI Platform Notebooks 에서 ML API 호출

1. notebook 인터페이스에서 training-data-analyst > courses > machine_learning > deepdive > 01_googleml > mlapis.ipynb 선택

2. 주석을 확인하며 파이썬 코드 실행 (Shift+Enter)

- 첫번째 코드셀에서 API Key를 발급받은 API Key로 대체

2-1) Jupyter Notebook 실습 코드 : 실행 전

2-2) Jupyter Notebook 실습 코드 : 실행 후

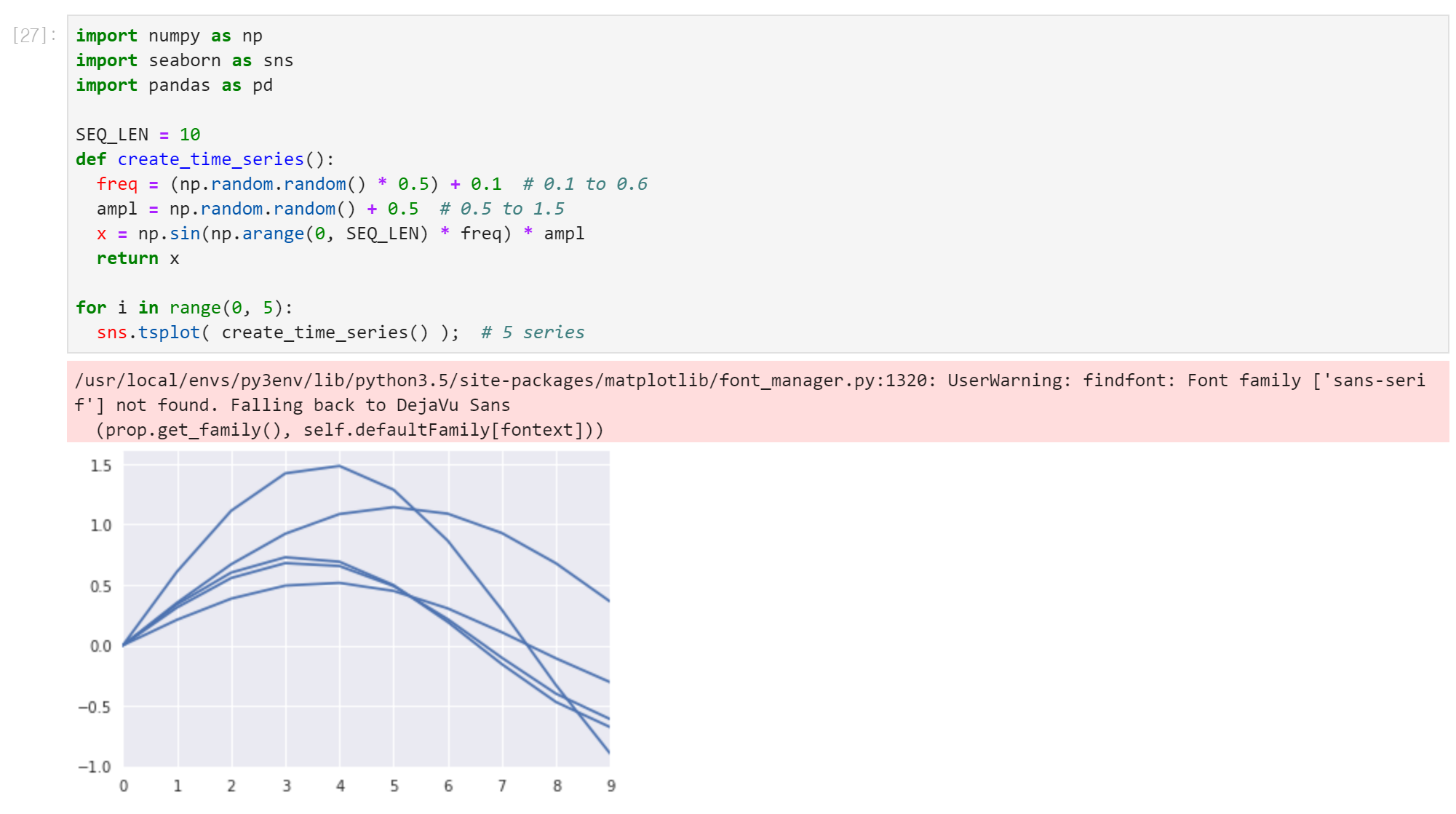

3. 반복 분할 (Repeatable Splitting)

- 머신 러닝 데이터 셋을 생성하는 다양한 방법

- notebook 인터페이스에서 training-data-analyst > courses > machine_learning > deepdive > 02_generalization > repeatable_splitting.ipynb 선택

3-1) Jupyter Notebook 코드 : 실행 전

3-2) Jupyter Notebook 코드 : 실행 후

4. ML 데이터 세트 탐색 및 생성

- 뉴욕시의 택시 승차에 해당하는 데이터를 탐색하여 요금 추정 도구를 지원하는 기계 학습 모델 샘플

- notebook 인터페이스에서 training-data-analyst > courses > machine_learning > deepdive > 02_generalization > labs > create_datasets.ipynb 선택

(Jupyter Notebook 실습 코드)

5. TensorFlow 활용 기초

- notebook 인터페이스에서 training-data-analyst > courses > machine_learning > deepdive > 03_tensorflow > labs > a_tfstart.ipynb 선택

5-1) Jupyter Notebook 실습 코드 : 모델

#TODO: Using your non-placeholder solution,

# try it now using tf.eager by removing the session

5-2) Jupyter Notebook 실습 코드 : 정답 포함

6. Feature Engineering

- notebook 인터페이스에서 training-data > analyst > courses > machine_learning > feateng > feateng.ipynb 선택

(Jupyter Notebook 실습 코드)

7. tf.transform 살펴보기

- notebook 인터페이스에서 training-data-analyst > courses > machine_learning > deepdive > 11_taxifeateng > tftransform.ipynb 선택

(Jupyter Notebook 실습 코드)

8. Hand-tuning hyperparameters

- notebook 인터페이스에서 training-data-analyst > courses > machine_learning > deepdive > 05_artandscience > labs > a_handtuning.ipynb 선택

(Jupyter Notebook 실습 코드)

9. Hyperparameters 튜닝

- notebook 인터페이스에서 training-data-analyst > courses > machine_learning > deepdive > 05_artandscience > labs > b_hyperparam.ipynb 선택

(Jupyter Notebook 실습 코드)

10. 뉴럴 네트워크 (Neural Networks)

- notebook 인터페이스에서 "Clone a repo" 버튼 클릭

Repository URL 입력 : https://github.com/GoogleCloudPlatform/training-data-analyst

- notebook 인터페이스에서 training-data-analyst > courses > machine_learning > deepdive > 05_artandscience > labs > c_neuralnetwork.ipynb 선택

(Jupyter Notebook 실습 코드)

11. Custom Estimator

- notebook 인터페이스에서 training-data-analyst > courses > machine_learning > deepdive > 05_artandscience > labs > d_customestimator.ipynb 선택

(Jupyter Notebook 실습 코드)

'Biusiness Insight > Gen AI · Data Analytics' 카테고리의 다른 글

| [구글 클라우드] 배치 기반 TensorFlow 스케일업 (0) | 2020.04.22 |

|---|---|

| [구글 클라우드] Estimator API 사용해서 AI 모델 구현 (TensorFlow) (0) | 2020.04.21 |

| [구글 클라우드] AI Platform Notebooks & BigQuery 를 사용한 데이터 분석 (0) | 2020.04.19 |

| [구글 클라우드] AI 플랫폼 활용 (0) | 2020.04.18 |

| [구글 클라우드 플랫폼] 강화학습 활용 예제 (Reinforcement Learning on GCP) (0) | 2020.04.05 |